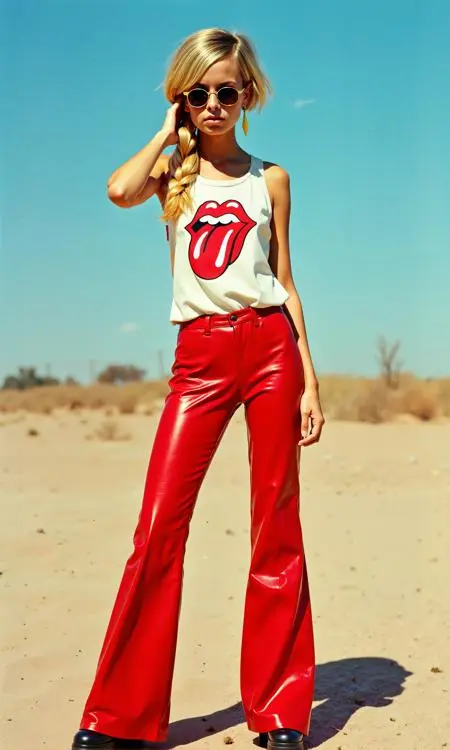

Twiggy [2.3MB 单变压器Flux LoRa]

0

0

0

0

PhotographyRealisticGirl

v1.0

Actualizado recientemente: Publicado por primera vez:

The LoRa was trained on just two single transformer blocks with a rank of 32, which allows for such a small file size to be achieved without any loss of quality.

Since the LoRa is applied to only two blocks, it is less prone to bleeding effects. Many thanks to 42Lux for their support.

Discusión

Más popular

|

Más nuevo

Enviar

Próximamente

Descargar

(0.00KB)

Detalles

Tipo

Recuento de generación en línea

0

Descargas

0

Parámetros RecomendadosAdd

Galería

Más popular

|

Más nuevo